Последствия алгоритма Google «Penguin»

Сегодня, друзья, я хочу поделиться с Вами информацией о том, как благодаря изменениям в поисковом алгоритме «Google» мой сайт потерял половину трафика (посетителей) с этого поисковика. Поскольку в сети Интернет мы имеем дело с веб-страницами, то (хотим мы того или нет) нам приходится вникать и в нюансы работы поисковых систем, которые их ранжируют. Как говорится: "Кто предупрежден, тот - вооружен". Как видите, мне это не помогло, так может быть поможет Вам? :)

Итак, начнем с самого начала. Что такое поисковый алгоритм? Это - большая совокупность мелких признаков, по которым поисковая система расставляет (ранжирует) сайты в результатах своей выдачи. Поэтому в задачу любого проекта входит - "понравиться" поисковым системам (их алгоритмам ранжирования).

И тут есть огромная разница между тем, находится ли наш ресурс на первой странице поисковой выдачи (в топе поисковой системы) или - на десятой. Как Вы понимаете, во втором случае на него вряд ли кто-то вообще зайдет. Вы часто просматриваете страницы с результатами поиска дальше третьей-четвертой страницы? Во-о-о-т... :)

Грубо говоря, поисковики делят все сайты на две большие категории:

- не несущие никакой пользы людям (сделанные исключительно для заработка на рекламе и т.д.) В просторечье - ГС (извините - говно-сайты)

-

и "белые", содержащие интересный для посетителей материал. Их еще называют "СДЛ"-сайты (сделано для людей).

Причем статьи (контент) на СДЛ сайтах обязательно должны быть уникальными. В идеале - написанными полностью с нуля, а не скопированными или переделанными текстами. В отношении этого пункта поисковые системы все туже "затягивают гайки" и не уникального текста на сайте, от греха подальше, вообще быть не должно!

Понятно, что алгоритмы поисковых систем по отношению к категории Интернет-ресурсов ГС постоянно применяют различные санкции и стараются вытеснить такие сайты из "серпа" или же вообще не индексировать, а "черные" Seo-шники, в свою очередь, все время стараются их запихнуть в выдачу, пользуясь какими-то лазейками в алгоритмах работы системы.

Ниже - перевод этой всей дребедени на "человеческий" язык :)

Примечание:

- результаты поисковой выдачи на жаргоне часто называют "серпом" (от англ. сокращения SERP - Search Engine Result Page - страница результатов поиска, выданная поисковым алгоритмом).

- индексация - видимость ресурса для поисковой системы, а значит - и для всех ее пользователей

- Черное SEO, черные (ГС) сайты и методы их продвижения, нарушающие основные правила поисковых систем

- SEO - (англ. Search Engine Optimization) - методы, которые используют оптимизаторы (сеошники) для улучшения позиций в поисковой выдаче

Методы SEO могут быть как "былыми" (одобряемыми самими поисковиками), которые помогают поисковым алгоритмам лучше "понимать" как правильно нужно индексировать тот или иной сайт и - "черными" - официально запрещенными. Черное SЕО направлено на искусственное манипулирование поисковым алгоритмом, его "накручивание", что в итоге приводит к не релевантным (не удовлетворяющим запросу пользователя) результатам поисковой выдачи.

Для поисковиков крайне важна чистота "серпа". Почему? Элементарно! Как говорил дядя Миша (Задорнов) - "Здесь все из за бабок и не надо лохматить бабушку!" :) Корпорация «Google», равно как и «Яндекс», львиную долю своей прибыли получают от платной рекламы, которую Вы можете видеть на многих сайтах в Интернете. На моем - тоже :)

И в этом контексте есть две категории людей: те, которые готовы размещать ее на страницах своих сайтов с целью заработка (веб-мастера) и те, которые готовы заплатить за ее размещение с целью показа своей рекламы на сайтах первых (рекламодатели). Как Вы догадываетесь, поисковые системы получают деньги с обеих категорий :) И суммарная прибыль здесь - огромна, поэтому есть за что бороться.

Вот поисковики и "борются". Ведь рекламодатель хочет видеть рекламу своих прокладок размещенную на качественном и тематическом ресурсе, а не на откровенном ГС, зайдя на который пользователь сразу же его закроет, так и не узнав про новые "крылышки" и революционный "аппликатор" :) А кто платит - тот и прав.

Все просто: если алгоритмы поисковых систем будут показывать нерелевантную выдачу, то и размещать рекламу там никто не захочет, потому как "выхлоп" от этого дела будет очень незначительным, а этого ни «Яндекс» ни «Google» допустить никак не могут!

О том, как поисковые системы радеют за чистоту выдачи можно судить по такой чудесной возможности, предоставляемой нам, как "заложи соседа", ну, или как-то так :)

Постоянно совершенствующиеся (читайте - "изменяющиеся") алгоритмы поисковых систем призваны фильтровать "серп" и не допускать в него поискового спама (некачественные ресурсы, продвигаемые методами черного SEO).

И вся эта борьба в теории выглядит очень прозрачно и правильно, но на практике может оказаться так, что Ваш (даже самый "белый" сайт) может пасть жертвой работы нового алгоритма поисковой системы. Ведь "сегодня" она понимает релевантность (соответствие страницы сайта поисковому запросу пользователя) так, а "завтра" (с введением нового алгоритма) - чуть-чуть по другому. И вот если Вы со своим сайтом попадаете в это "чуть-чуть", то тут два варианта: либо "большой брат" Вас круто поднимет, либо - опустит ... в выдаче :)

Свои алгоритмы поисковых систем разработчики держат в страшной тайне и любовно называют разными красивыми именами и названиями. У зеркала Рунета (Яндекса) это знаменитая "игра в города" - «Магадан», «Находка», «Арзамас», «Снежинск». У «Google» здесь нет какой-то устоявшейся линии поведения и это могут быть названия такого вида: «Кофеин», «Панда» и т.д. Причем существуют разные версии этих алгоритмов, которые в той или иной степени влияют на общую выдачу. Насколько я знаю, «Панду» "раскормили" до версии 3,4.

И вот, в ночь с 24-го на 25-е апреля 2012-го года, вероломно, без объявления войны и претензий, Гугл выпустил из "клетки" нового страшного зверя ... пингвина :)

Новый поисковый алгоритм получил название «Google Penguin» (пингвин). Буквально на следующий день мой счетчик статистики посещаемости показал резкое падение трафика с данной поисковой системы. Таким резким оно за один день быть не может по определению (это же не Новый год!), поэтому я сразу заподозрил что-то не ладное и начал наводить справки в Интернете.

Оказалось, что не я один такой "везучий" и косолапый пингвин потоптался по многим сайтам. Уверен, что определенный их процент ощутил после этого прирост посетителей, а вот большинство - наоборот. Ну, скажем так, наверное о степени адекватности нового алгоритма может говорить тот факт, что в сети сразу же появился ресурс, который стал собирать подписи веб-мастеров за его отмену.

Причем в период введения алгоритма в работу (где-то на протяжении 3-4-х дней) наблюдался своеобразный "Гугл-дэнс". Позиции страниц сайта (не только моего) в выдаче хаотично "прыгали" вверх-вниз, попадая то в ТОП, то через несколько часов вылетая за пределы первой сотни. Выдачу "трясло" по взрослому! :)

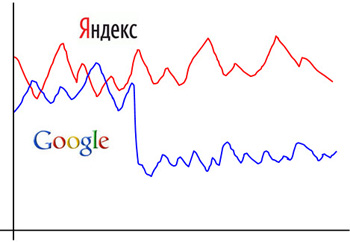

К сожалению я сейчас не могу найти тот самый график из Интернет-статистики, но я воспроизвел его от руки. Рисунок ниже вполне адекватно передает суть того, что произошло:

Раньше трафик с обеих поисковых систем распределялся на моем сайте почти поровну, но начиная с 25-го апреля, трафик с «Google» резко упал и начал рисовать свою "кардиограмму" уже на другом уровне.

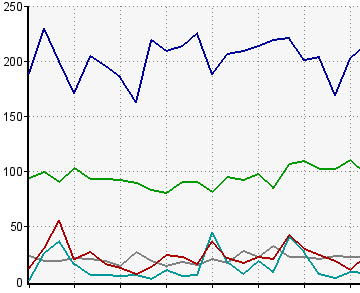

Сейчас, по прошествии полутора месяцев ситуация не изменилась и реальная статистика выглядит у меня вот так:

Зеленая линия - Гугл.

Что я сделал в первую очередь? Попытался связаться с "большим братом" и выяснить, не наложен ли на мой проект какой-то фильтр? Так как полной уверенности насчет "пингвина" у меня тогда не было.

Примечание: фильтр - искусственное понижение (удаление) ресурса из выдачи из за несоответствия требованиям к качеству или нарушения каких-либо основополагающих правил поисковой системы (ПС). Фильтр вручную накладывается сотрудниками компании ПС и снимается через некоторое (может быть - весьма продолжительное) время, когда все замечания и исправления будут учтены и введены владельцем ресурса.

Фильтры ПС также носят индивидуальные названия, например - «Песочница» или «АГС-17» (его модификация - «АГС-30»). Это - сито, которое нужно для отсеивания из ТОП-а низкокачественных ресурсов. Кстати, название знаменитого фильтра Яндекса расшифровывается как "автоматический гранатомет станковый". Таким образом, по видимому, "зеркало Рунета" хочет продемонстрировать, что будет с проектами, которые оно посчитает некачественными.

Но, - продолжаем! Связаться со службой поддержки какой-либо ПС проще всего из соответствующей панели веб-мастера, в которой обязан быть зарегистрированным каждый уважающий себя владелец сайта.

Для «Яндекса» это - webmaster.yandex.ru, а для «Google» - google.com/webmasters. Вводим свой логин и пароль, указанные нами при регистрации в данном инструменте и переходим вот по такому адресу:

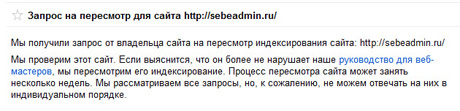

https://google.com/webmasters/tools/reconsideration?hl=ru

И в форме показанной ниже, мы можем подать заявку на переиндексацию нашего сайта, с целью понимания того, не нарушает ли он каких-либо правил по обеспечению качества поиска данной ПС.

Картинка - кликабельна.

Во время заполнения формы я подробно описал возникшую ситуацию, изложил методы "белого" продвижения проекта и робко выразил надежду на то, что алгоритм поисковой системы, видимо, ошибся, в связи с чем требуется его повторная переиндексация :)

После отправки заполненной формы я увидел вот такую надпись:

Вот так вот, развиваешь проект, никого не трогаешь и тут оказывается что ты - злостный нарушитель правил и попиратель устоев :) Делать нечего - ждем результатов сканирования.

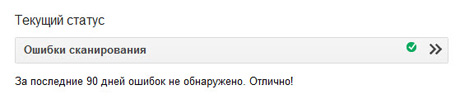

А пока мы ждем, хочу обратить Ваше внимание на тот факт, что в панели веб-мастера Гугла (равно как и Яндекса) есть раздел сообщений и ошибок сканирования, в который я настоятельно рекомендую время от времени заглядывать. Как правило, там отображается критически важная для владельца сайта информация (имеет ли поисковый робот доступ к ресурсу, какие ошибки выявлены при его сканировании и т.д.). Эти данные могут быть очень важными для оперативного реагирования на ранней стадии возникновения действительно серьезной проблемы.

Если Вы видите примерно вот такую картину, значит - все нормально:

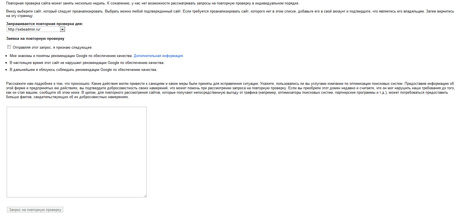

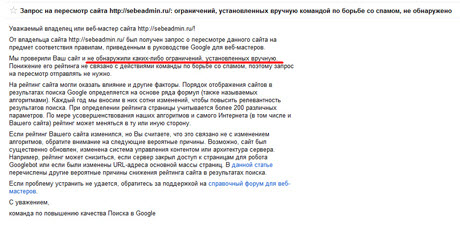

Воодушевившись подобным результатом, я стал ждать переиндексации. Недели через две она таки состоялась, но не скажу, что ее итог меня сильно обрадовал:

Картинка также кликабельна.

В этом ответе есть один важный момент, требующий пояснения. Примененные санкции могут быть вызваны работой поискового алгоритма или же - наложены вручную сотрудниками команды по повышению качества поиска. И после подачи заявки на пересмотр проверяется именно этот факт. Поэтому фраза "Мы проверили Ваш сайт и не обнаружили каких-либо ограничений, установленных вручную" имеет глубинный смысл, состоящий в следующем.

Дело в том, что веб-ресурс к которому штрафные санкции были необоснованно применены в "ручном" режиме, может (после подачи заявки) рассчитывать на их пересмотр и отмену. А вот с "порчей", наведенной поисковым алгоритмом - дело куда как сложнее :) Позиция сотрудников Гугла здесь однозначна - они не вмешиваются в его работу, считая что искусственный интеллект непогрешим в этом вопросе. И никакая переиндексация тут уже не поможет.

Есть такая выдержка из анекдота, как нельзя лучше подходящая к данной ситуации: "Меня к Вам послали... Э-э-э.. может быть - "направили"? Да, нет же - именно "послали"! ". Приблизительно это и делает ПС в данном случае, только очень корректно :)

С другой стороны - «Google» постоянно декларирует, что после приведения площадки в соответствие со всеми требованиями (читайте - "вымогательствами" :) ) поисковой системы она, с течением времени, обязательно поднимется в выдаче. Вот только как будет называться поисковый алгоритм, с которым Вам придется бороться тогда?

Не подумайте, друзья, что такие вещи, как изменение алгоритма поисковых систем как-то сильно расстраивают меня. Скорее я пишу эти строки для того, чтобы те люди, которые сами хотят создать сайт в будущем знали о таких вещах и спокойно на них реагировали. И еще - старайтесь создавать только СДЛ ресурсы (для людей), и так в сети достаточно мусора и дублированного контента, а работой поисковых систем не очень озадачивайтесь. У них - своя "кухня" у нас - своя :)

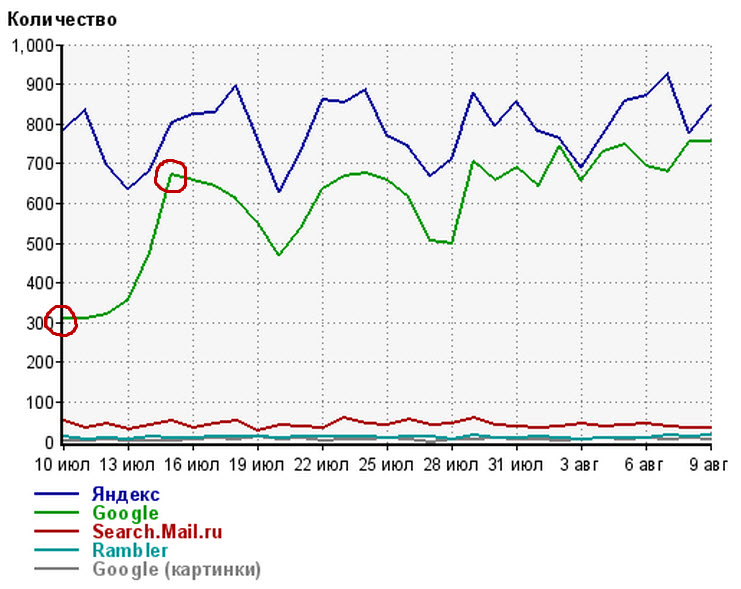

P.S. Сейчас на дворе лето 2013-го и недавно в биографии сайта произошло событие, которое заслуживат отдельного упоминания. Несколько месяцев назад, великий и ужасный Google "выпустил" наш сайт из под своего фильтра! На графике посещаемости для проекта SebeAdmin это отображается вот так:

Как видим, точкой отсчета можно считать 13-е июля. Конечно, я, как владелец сайта, предпринимал определенные действия в надежде выйти из под фильтра поисковой системы, но, честно говоря, никакой уверенности в положительном результате своих действий у меня не было. Особенно, после прочтения различных "умных" советов и историй "бывалых" оптимизаторов на многочисленных форумах и блогах в Интернете :)

Но, как видите, все получилось как нельзя лучше! Что лишний раз подтверждает: пробуйте и действуйте сами, не слушайте если Вам говорят "не получится" и все, в конечном счете, будет замечательно!

Идёт загрузка...

Идёт загрузка...